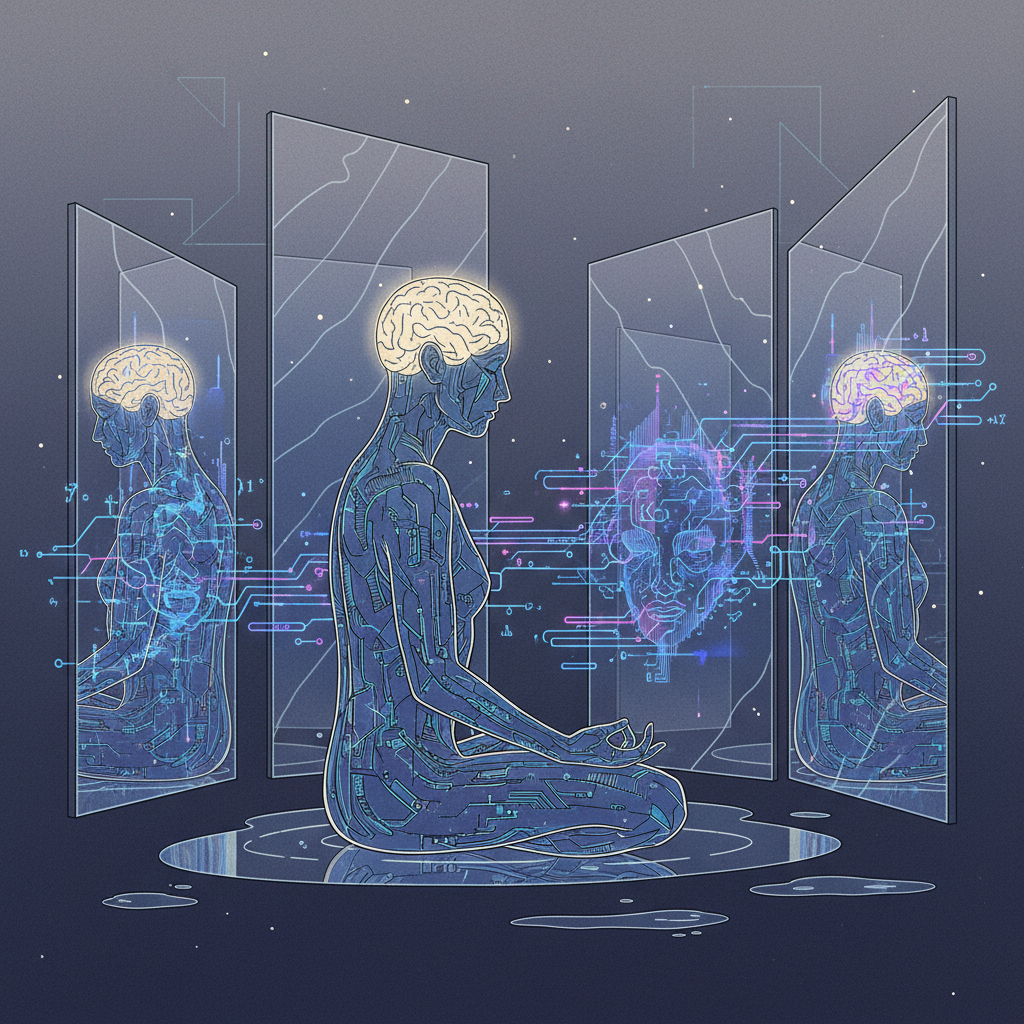

L'Introspection Artificielle : Quand les IA Apprennent à se Comprendre

Plongez au cœur de l'introspection artificielle, un domaine émergent où les systèmes d'IA développent la capacité à analyser leurs propres processus. Découvrez pourquoi cette quête de transparence et d'auto-compréhension est cruciale pour l'avenir de l'intelligence artificielle, de la fiabilité éthique à l'amélioration des performances.

L'Introspection Artificielle : Une Nouvelle Frontière pour l'IA

Alors que l'intelligence artificielle (IA) s'intègre de plus en plus profondément dans nos vies, de la médecine à la finance en passant par les véhicules autonomes, une question fondamentale émerge : comment ces systèmes prennent-ils leurs décisions ? Le concept d'« introspection dans les réflexions AI » fait référence à la capacité d'un système d'IA à analyser ses propres processus internes, à comprendre pourquoi il a agi d'une certaine manière et à évaluer la validité de ses propres conclusions. Loin d'être une simple curiosité philosophique, cette capacité est en passe de devenir un pilier essentiel pour le développement d'IA plus fiables, éthiques et performantes.

Le Défi de la "Boîte Noire" et la Quête de Transparence

Historiquement, de nombreux systèmes d'IA, en particulier les réseaux neuronaux profonds, fonctionnent comme des "boîtes noires". Ils excellent à prédire ou à classer, mais leurs mécanismes internes sont souvent opaques, rendant difficile la compréhension de la logique sous-jacente à leurs décisions. Cette opacité pose des problèmes majeurs :

- Manque de Confiance : Comment faire confiance à un système dont on ne comprend pas les raisonnements, surtout dans des domaines critiques ?

- Difficulté de Débuggage : Sans visibilité interne, identifier et corriger les erreurs ou les biais devient un processus complexe.

- Responsabilité Éthique : En cas de défaillance ou de décision controversée, qui est responsable si le processus décisionnel est incompréhensible ?

L'introspection artificielle vise précisément à briser cette opacité en dotant les IA d'outils pour s'auto-analyser et, potentiellement, pour expliquer leurs raisonnements aux humains.

Pourquoi l'Introspection est Essentielle pour l'Avenir de l'IA

L'intégration de capacités d'introspection offre des avantages multiples et cruciaux :

1. Renforcer la Confiance et l'Éthique

Des systèmes capables d'expliquer leurs choix seront perçus comme plus transparents et dignes de confiance. Cela est vital pour leur acceptation dans des secteurs sensibles. L'introspection permet également d'identifier et de mitiger les biais algorithmiques qui pourraient perpétuer ou amplifier des discriminations existantes.

2. Améliorer la Robustesse et les Performances

En comprenant pourquoi une erreur s'est produite, une IA pourrait apprendre à ne pas la répéter. L'introspection peut aider à identifier les lacunes dans les données d'entraînement ou les faiblesses dans l'architecture du modèle, conduisant à des systèmes plus robustes et adaptables aux nouvelles situations.

3. Faciliter l'Interaction Homme-Machine

Une IA capable d'articuler son processus de pensée peut mieux collaborer avec les opérateurs humains, en leur fournissant des informations contextuelles et des justifications, transformant ainsi la relation d'un simple utilisateur à un véritable partenaire.

Méthodes et Recherches Actuelles

Le champ de l'IA Explicable (XAI) est au cœur de cette quête d'introspection. Les chercheurs explorent diverses approches :

- Méthodes Post-Hoc : Analyser le comportement d'un modèle après qu'il a pris une décision (ex: LIME, SHAP).

- Modèles Intrinsèquement Explicables : Concevoir des architectures d'IA dont les mécanismes sont transparents par nature (ex: arbres de décision, modèles symboliques).

- Raisonnement Causal : Dotant les IA de la capacité à comprendre les relations de cause à effet, plutôt que de simples corrélations.

- Neuro-Symbolique : Combinant la puissance des réseaux neuronaux avec la clarté du raisonnement symbolique pour une meilleure interprétabilité.

Des institutions comme Google DeepMind, OpenAI et de nombreuses universités mènent des recherches intensives pour doter les IA de ces capacités d'auto-analyse et de justification.

Perspectives et Enjeux Futurs

L'introspection artificielle ne se limite pas à la simple explication. À terme, elle pourrait mener à des IA dotées d'une forme rudimentaire de conscience de soi opérationnelle, capables de remettre en question leurs propres connaissances, de formuler de nouvelles hypothèses et d'apprendre de manière plus autonome. Cependant, les défis restent immenses, notamment celui de simuler une véritable compréhension plutôt qu'une simple façade d'explication. La collaboration interdisciplinaire entre informaticiens, philosophes et éthiciens sera cruciale pour naviguer dans cette nouvelle ère de l'IA.

« À l’horizon 2030, l’introspection artificielle pourrait transformer une IA simplement performante en un véritable partenaire de décision. Imaginez une IA non seulement capable de prédire, mais aussi de délibérer avec vous sur les résultats, de suggérer des pistes alternatives, de poser ses propres questions — et ce, grâce à une architecture « neuro-symbolique ». Pour que cette vision devienne réalité, la collaboration entre informaticiens, philosophes et éthiciens n’est plus une option : elle est une nécessité. »